La reconnaissance émotionnelle s’impose progressivement dans nos sociétés, promettant de décoder nos états affectifs par l’analyse de nos expressions faciales, notre voix ou nos données biométriques. Cette capacité à interpréter algorithmiquement nos émotions soulève des questions fondamentales touchant à la vie privée, au consentement et à la dignité humaine. Alors que les applications se multiplient dans des domaines aussi variés que le recrutement, la sécurité ou le marketing, le cadre juridique peine à suivre cette évolution technologique. Face à ces défis, législateurs et régulateurs internationaux commencent à élaborer des règles spécifiques pour encadrer ces dispositifs dont le potentiel intrusif n’a d’égal que la fragilité scientifique de leurs fondements.

Le fonctionnement et les applications des technologies de reconnaissance émotionnelle

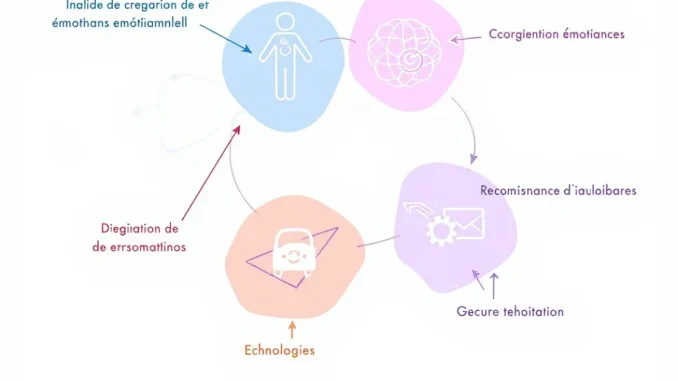

La reconnaissance émotionnelle repose sur différentes méthodes d’analyse algorithmique visant à identifier et catégoriser les émotions humaines. Ces technologies s’appuient principalement sur trois approches: l’analyse des expressions faciales, le traitement des signaux vocaux et l’interprétation des données physiologiques.

L’analyse faciale constitue la méthode la plus répandue. Elle s’appuie sur des algorithmes qui décomposent le visage en points de référence et mesurent leurs mouvements pour les associer à des émotions prédéfinies. Les entreprises comme Affectiva ou Emotient (rachetée par Apple) ont développé des systèmes capables de reconnaître jusqu’à sept émotions dites universelles: joie, tristesse, colère, peur, dégoût, surprise et neutralité. Ces systèmes utilisent l’apprentissage automatique pour affiner leurs prédictions à partir d’immenses bases de données d’expressions faciales.

L’analyse vocale, quant à elle, examine les modulations de la voix, le débit de parole, les micropauses et les variations tonales pour détecter des états émotionnels. Des entreprises comme Beyond Verbal ou Nemesysco commercialisent des solutions qui prétendent identifier le stress, la nervosité ou l’enthousiasme dans les communications orales.

Enfin, l’approche physiologique mobilise des capteurs mesurant les réactions corporelles comme la sudation, le rythme cardiaque ou la dilatation pupillaire. Ces données, recueillies par des wearables ou des dispositifs spécialisés, sont analysées pour évaluer l’état émotionnel d’un individu.

Domaines d’application en expansion

Les secteurs d’application de ces technologies se multiplient rapidement:

- Le recrutement et la gestion des ressources humaines, où des entreprises comme HireVue proposent d’analyser les émotions des candidats lors d’entretiens vidéo

- Le marketing et la publicité, qui utilisent ces outils pour mesurer les réactions émotionnelles aux produits ou aux campagnes

- La sécurité et la surveillance, avec des systèmes prétendant détecter des intentions malveillantes dans les espaces publics

- La santé, notamment pour le suivi de patients atteints de troubles psychologiques

- L’éducation, pour évaluer l’engagement et les difficultés des apprenants

Cette prolifération suscite des inquiétudes majeures. Les chercheurs en sciences affectives comme Lisa Feldman Barrett remettent en question les fondements scientifiques de ces technologies, arguant que les émotions ne s’expriment pas de manière universelle et standardisée. Par ailleurs, de nombreuses études ont démontré des biais significatifs dans ces systèmes, particulièrement envers les minorités ethniques et les personnes présentant certains handicaps.

La fiabilité de ces technologies reste donc sujette à caution, alors même que leurs décisions peuvent avoir des conséquences considérables sur la vie des individus, qu’il s’agisse d’accès à l’emploi, de diagnostic médical ou de suspicion sécuritaire.

Cadre juridique actuel: entre vide réglementaire et adaptations progressives

Le cadre juridique encadrant les technologies de reconnaissance émotionnelle demeure fragmenté et incomplet. Cette situation résulte principalement de la nouveauté de ces technologies et de leur développement plus rapide que l’évolution des normes juridiques. Néanmoins, plusieurs dispositifs réglementaires existants peuvent s’appliquer, au moins partiellement.

Dans l’Union européenne, le Règlement Général sur la Protection des Données (RGPD) constitue le principal outil de régulation. Les données captées par les systèmes de reconnaissance émotionnelle sont généralement considérées comme des données personnelles, voire des données sensibles lorsqu’elles permettent de déduire des informations sur la santé psychique des personnes. L’article 9 du RGPD interdit en principe le traitement de ces données sensibles, sauf exceptions strictement définies comme le consentement explicite. De plus, l’article 22 limite les décisions individuelles automatisées fondées uniquement sur un traitement algorithmique, offrant une protection contre les usages les plus intrusifs de ces technologies.

La proposition de règlement sur l’intelligence artificielle présentée par la Commission européenne en avril 2021 va plus loin. Elle classe explicitement certains usages de la reconnaissance émotionnelle parmi les applications à haut risque, notamment dans les domaines de l’éducation et de l’emploi. Ces applications seraient soumises à des obligations renforcées: évaluation de conformité préalable, documentation technique détaillée, supervision humaine et transparence envers les personnes concernées.

Aux États-Unis, l’approche est plus fragmentée. Au niveau fédéral, aucune législation spécifique n’encadre ces technologies. La Federal Trade Commission (FTC) peut néanmoins intervenir en cas de pratiques commerciales déloyales ou trompeuses, notamment lorsque les entreprises exagèrent les capacités de leurs systèmes. Au niveau des États, quelques initiatives émergent. L’Illinois Biometric Information Privacy Act (BIPA) exige le consentement préalable pour la collecte de données biométriques, ce qui peut s’appliquer à certains systèmes de reconnaissance émotionnelle. En 2021, la Californie a introduit une législation imposant des avertissements explicites lorsque ces technologies sont utilisées dans les publicités numériques.

En Chine, paradoxalement, la réglementation avance rapidement. Les Dispositions sur la protection des informations biométriques publiées en 2021 encadrent strictement la collecte d’informations faciales et vocales, tout en autorisant leur usage pour la sécurité publique. Cette approche témoigne d’une volonté de contrôler ces technologies tout en préservant leur utilité pour la surveillance étatique.

Ces cadres juridiques existants présentent toutefois d’importantes lacunes. La nature même des émotions, qui ne sont pas des caractéristiques fixes comme les empreintes digitales, complique leur qualification juridique. De plus, la validité scientifique contestée de ces technologies pose la question de la responsabilité en cas d’erreur d’interprétation. Enfin, l’application transfrontalière des règles demeure problématique face à des technologies déployées mondialement.

Les risques juridiques et éthiques majeurs

L’utilisation des technologies de reconnaissance émotionnelle soulève des enjeux juridiques et éthiques considérables qui justifient un encadrement renforcé. Ces risques touchent aux droits fondamentaux des individus et à l’organisation sociale dans son ensemble.

La question de la vie privée se pose avec une acuité particulière. Ces technologies franchissent une frontière inédite en prétendant accéder à la sphère intime des émotions, traditionnellement protégée des regards extérieurs. Comme l’a souligné la Cour européenne des droits de l’homme dans plusieurs arrêts, le respect de la vie privée implique la protection d’un espace personnel où l’individu peut développer sa personnalité sans intrusion. La reconnaissance émotionnelle menace directement cet espace en transformant les manifestations émotionnelles, souvent involontaires, en données exploitables. Cette capacité d’observation permanente peut engendrer un effet disciplinaire, incitant les individus à contrôler leurs expressions naturelles pour éviter des interprétations algorithmiques défavorables.

Le risque de discrimination constitue une autre préoccupation majeure. De nombreuses études, dont celles menées par des chercheurs de l’Université de Cambridge et du MIT, démontrent que ces technologies présentent des taux d’erreur significativement plus élevés pour certains groupes démographiques, notamment les femmes à peau foncée. Cette disparité s’explique par les biais présents dans les données d’entraînement et par l’universalisation abusive de modèles émotionnels occidentaux. L’utilisation de ces systèmes dans des contextes décisionnels comme l’embauche ou l’accès à des services peut donc renforcer les discriminations existantes, en violation des principes d’égalité garantis par de nombreuses constitutions et conventions internationales.

Manipulation et consentement compromis

Le risque de manipulation apparaît particulièrement préoccupant. En identifiant les états émotionnels, ces technologies permettent d’adapter en temps réel les contenus ou les interactions pour maximiser certaines réactions. Dans le domaine commercial, cette capacité peut être utilisée pour cibler les consommateurs à leurs moments de vulnérabilité émotionnelle. Le Conseil de l’Europe a alerté sur ces pratiques qui peuvent constituer des formes de manipulation contraires à l’autonomie individuelle et à la dignité humaine.

La question du consentement libre et éclairé se pose avec force. Comment garantir un consentement véritable face à des technologies souvent invisibles ou intégrées à des services incontournables? La Commission Nationale Informatique et Libertés (CNIL) française a souligné cette difficulté dans un rapport de 2019, notant que l’asymétrie informationnelle entre les concepteurs de ces systèmes et les personnes concernées compromet la possibilité d’un consentement informé.

Enfin, ces technologies soulèvent des questions fondamentales sur la dignité humaine et la réduction algorithmique de la complexité émotionnelle. En classifiant les émotions en catégories prédéfinies, ces systèmes opèrent une simplification qui nie la richesse et l’ambiguïté des expériences humaines. Cette approche mécaniste des émotions peut conduire à une forme d’aliénation où l’individu se voit dépossédé de l’interprétation de ses propres états affectifs au profit d’une évaluation externe automatisée.

- Atteinte à la vie privée émotionnelle

- Risques de discrimination algorithmique

- Potentiel de manipulation comportementale

- Fragilisation du consentement

- Menace pour la dignité et l’autonomie interprétative

Ces risques substantiels appellent des réponses juridiques adaptées, allant au-delà des protections générales existantes pour tenir compte de la spécificité de ces technologies qui touchent à l’essence même de l’expérience humaine.

Vers un cadre réglementaire spécifique

Face aux risques identifiés, plusieurs initiatives réglementaires émergent pour encadrer spécifiquement les technologies de reconnaissance émotionnelle. Ces efforts témoignent d’une prise de conscience croissante des enjeux particuliers liés à ces dispositifs.

L’Union européenne se positionne à l’avant-garde de cette régulation avec son projet de règlement sur l’intelligence artificielle. Dans sa version adoptée par le Parlement européen en juin 2023, ce texte prévoit des dispositions spécifiques concernant la reconnaissance des émotions. Il impose une transparence renforcée, obligeant les développeurs à informer clairement les utilisateurs lorsqu’ils sont soumis à ces technologies. Pour certains usages classés à haut risque, comme dans le recrutement ou l’éducation, des évaluations d’impact obligatoires et des mécanismes de supervision humaine sont exigés.

Les débats au sein des institutions européennes ont même conduit à envisager l’interdiction pure et simple de certaines applications. La commission LIBE du Parlement européen a ainsi proposé de prohiber l’usage de la reconnaissance émotionnelle dans les espaces publics et les environnements de travail, considérant que les risques d’atteinte aux droits fondamentaux y sont disproportionnés par rapport aux bénéfices allégués.

Aux États-Unis, plusieurs initiatives législatives se développent au niveau local. La ville de Portland a adopté en 2021 une ordonnance interdisant l’usage commercial des technologies de reconnaissance faciale, incluant explicitement les systèmes d’analyse émotionnelle. L’État de New York examine actuellement un projet de loi (BIPA-NY) qui exigerait un consentement écrit préalable pour toute collecte de données biométriques, y compris celles utilisées pour la reconnaissance émotionnelle.

Au niveau fédéral, l’Algorithmic Accountability Act, réintroduit au Congrès en 2022, pourrait imposer aux entreprises utilisant des systèmes automatisés, dont la reconnaissance émotionnelle, de conduire des évaluations d’impact régulières et de démontrer l’absence de discrimination.

Principes directeurs pour une régulation adaptée

Au-delà de ces initiatives spécifiques, plusieurs principes directeurs émergent pour guider l’élaboration d’un cadre réglementaire adapté :

- Le principe de validité scientifique: exiger des preuves solides de la fiabilité des systèmes avant leur déploiement

- Le principe de proportionnalité: n’autoriser l’usage de ces technologies que lorsque l’objectif poursuivi ne peut être atteint par des moyens moins intrusifs

- Le principe de transparence algorithmique: imposer l’explicabilité des décisions et des inférences émotionnelles

- Le principe de consentement renforcé: garantir un consentement explicite, spécifique et révocable

- Le principe de supervision humaine: maintenir un contrôle humain significatif sur les décisions basées sur ces technologies

La Commission nationale de l’informatique et des libertés (CNIL) française a formulé des recommandations complémentaires, suggérant notamment l’instauration de moratoires sur certains usages, le temps d’établir un cadre éthique solide. Elle préconise l’adoption d’une approche graduée, où le niveau d’encadrement dépendrait de la sensibilité du contexte d’utilisation.

Des organismes internationaux comme l’UNESCO et l’OCDE ont publié des lignes directrices éthiques qui, sans avoir force de loi, influencent les développements réglementaires. La Recommandation sur l’éthique de l’intelligence artificielle adoptée par l’UNESCO en 2021 souligne spécifiquement la nécessité de protéger l’autonomie émotionnelle des individus face aux systèmes automatisés.

Ces différentes initiatives témoignent d’une volonté partagée d’établir un équilibre entre l’innovation technologique et la protection des droits fondamentaux. Elles reconnaissent la spécificité des technologies de reconnaissance émotionnelle qui, touchant à l’intimité psychique des personnes, appellent des garanties renforcées par rapport à d’autres applications de l’intelligence artificielle.

Pour une éthique de la reconnaissance émotionnelle

Au-delà du cadre juridique strict, l’encadrement des technologies de reconnaissance émotionnelle nécessite une réflexion éthique approfondie impliquant l’ensemble des parties prenantes. Cette démarche doit viser à établir des normes et des pratiques responsables qui complètent la régulation formelle.

La question de la légitimité de ces technologies constitue un préalable fondamental. Toutes les applications ne présentent pas le même niveau d’acceptabilité sociale et éthique. Si l’utilisation dans le domaine médical, pour aider au diagnostic de certains troubles psychologiques, peut se justifier par un bénéfice thérapeutique sous contrôle professionnel, l’analyse émotionnelle systématique des consommateurs à des fins publicitaires soulève des questions éthiques bien plus problématiques. Le Comité consultatif national d’éthique français recommande ainsi d’établir une distinction claire entre les usages légitimes, soumis à un encadrement proportionné, et les usages illégitimes qui devraient être proscrits.

La co-construction des normes éthiques apparaît comme une nécessité. Les chercheurs en éthique de l’IA comme Luciano Floridi ou Kate Crawford plaident pour une approche participative associant développeurs, utilisateurs, régulateurs et représentants de la société civile. Des initiatives comme le Partnership on AI ou l’IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems s’inscrivent dans cette perspective en élaborant des standards éthiques partagés. Cette approche multi-acteurs permet d’intégrer des perspectives diverses et de dépasser une vision purement techniciste des enjeux.

Responsabilité des concepteurs et éducation des utilisateurs

La responsabilité des concepteurs constitue un élément central de cette éthique appliquée. Le principe d’ethics by design implique d’intégrer les considérations éthiques dès la conception des systèmes, et non comme une réflexion a posteriori. Concrètement, cela peut se traduire par:

- L’adoption de méthodologies de développement intégrant des évaluations d’impact sur les droits fondamentaux

- La constitution d’équipes pluridisciplinaires incluant des spécialistes des sciences humaines

- La mise en place de processus de test rigoureux pour identifier et corriger les biais

- Le développement de mécanismes permettant aux utilisateurs de contester les interprétations algorithmiques

Plusieurs entreprises pionnières comme Microsoft et IBM ont publié des chartes éthiques spécifiques pour l’analyse émotionnelle, s’engageant notamment à ne pas déployer ces technologies dans certains contextes sensibles. Ces initiatives volontaires, bien qu’insuffisantes à elles seules, contribuent à établir des standards de bonnes pratiques pour l’industrie.

L’éducation des utilisateurs représente un autre pilier essentiel. La littératie numérique doit inclure une compréhension des possibilités et des limites des technologies de reconnaissance émotionnelle. Les citoyens doivent être informés de l’existence de ces systèmes, de leurs modalités de fonctionnement et des moyens de protéger leur vie privée émotionnelle. Des programmes éducatifs comme ceux développés par la Fondation Internet Nouvelle Génération contribuent à cette sensibilisation.

La recherche interdisciplinaire joue un rôle crucial dans cette démarche éthique. Les collaborations entre informaticiens, psychologues, sociologues et juristes permettent d’approfondir notre compréhension des implications sociales de ces technologies. Le Centre for Research and Technology in Artificial Intelligence a ainsi lancé un programme spécifique sur les dimensions éthiques de la reconnaissance émotionnelle, produisant des recommandations qui nourrissent le débat public et orientent les politiques réglementaires.

Enfin, l’établissement de mécanismes de certification indépendants pourrait offrir des garanties supplémentaires. À l’image du label IDEC pour la protection des données, un système de certification spécifique aux technologies d’analyse émotionnelle permettrait d’identifier les solutions respectueuses des standards éthiques et juridiques. Cette approche incitative compléterait utilement le cadre réglementaire contraignant.

L’éthique de la reconnaissance émotionnelle ne se limite donc pas à un ensemble de principes abstraits, mais se concrétise dans des pratiques, des mécanismes de gouvernance et des dispositifs éducatifs qui, ensemble, peuvent contribuer à un développement responsable de ces technologies.